IA al Volante: El Cerebro que Toma Decisiones en los Sistemas ADAS 2025

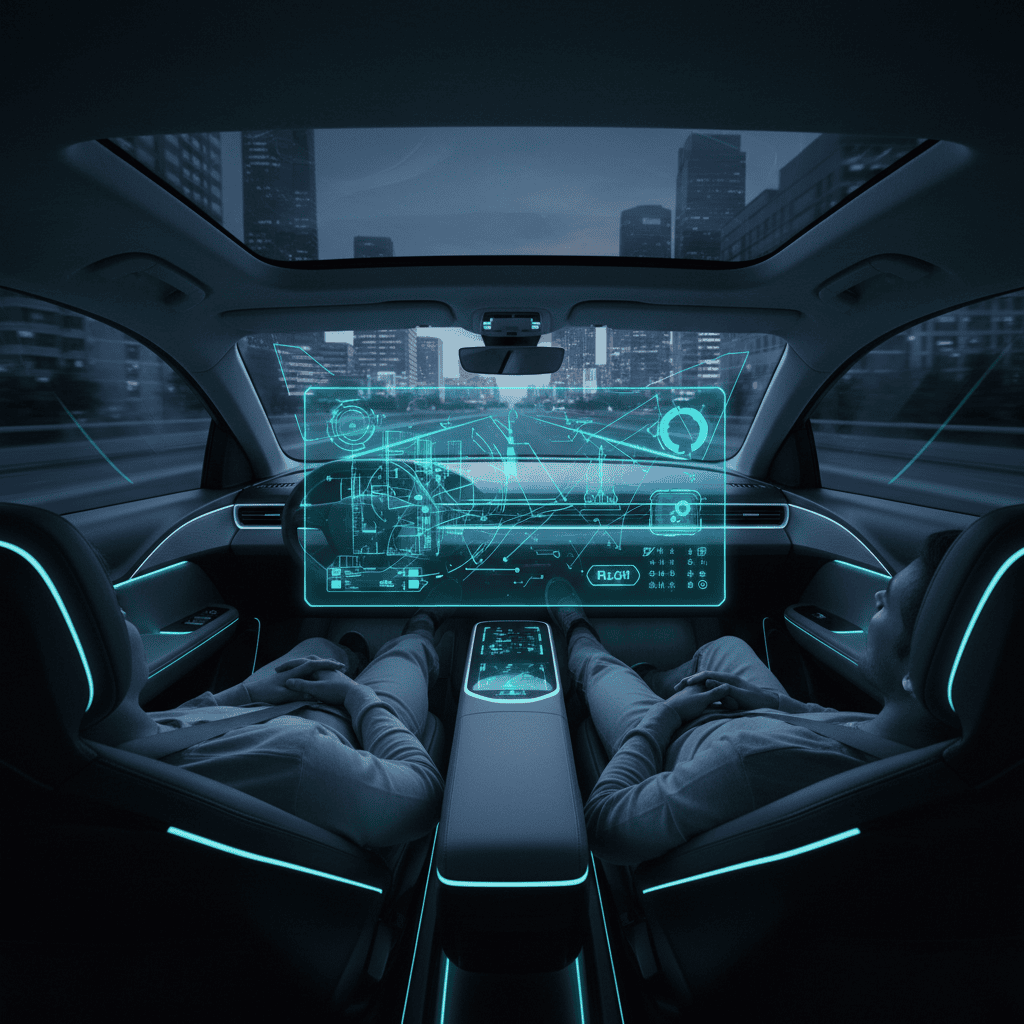

Si los sensores son los "ojos" de un coche autónomo y la conectividad V2X es su "voz", entonces la Inteligencia Artificial es su "cerebro". Pero a diferencia de un cerebro humano que actúa por instinto, la IA del volante debe tomar decisiones críticas de seguridad en milisegundos, transparentemente y dentro de marcos regulatorios que aún se están escribiendo.

En 2025, mientras los coches conducen solos por nuestras ciudades, surge una pregunta incómoda: ¿quién es responsable cuando falla? No es una pregunta técnica, es una pregunta moral que la industria, la regulación y la sociedad deben responder juntas.

¿Cómo Decide la IA en Milisegundos?

El proceso de decisión de un vehículo autónomo es un pipeline complejo donde cada etapa ocurre en paralelo:

1 milisegundo en la mente de la máquina: El coche viaja a 100 km/h (27,7 m/s). En un solo milisegundo, avanza 2,77 centímetros. Ese es el horizonte temporal en el que la IA debe procesar el mundo, predecir qué sucederá en los próximos 5 segundos y decidir qué hacer. En ese mismo tiempo, tu ojo humano ni siquiera ha parpadeado.

El Pipeline de Decisión en 4 Etapas:

- Percepción (10-50 ms): Los sensores envían datos. El sistema funde cámaras, radar y LiDAR en una única representación 3D del mundo.

- Predicción (20-100 ms): La IA predice dónde estarán los peatones, ciclistas y otros coches en los próximos 5 segundos. ¿Cruzará ese peatón? ¿Acelerará el coche de adelante?

- Planificación (50-200 ms): Genera 10-100 trayectorias posibles y elige la más segura. ¿Frenar? ¿Cambiar de carril? ¿Acelerar?

- Control (5-20 ms): Envía órdenes precisas: ángulo de giro, presión del freno, aceleración.

Los Tipos de IA en Conducción Autónoma

No toda IA es igual. En los sistemas ADAS 2025, coexisten diferentes enfoques, cada uno con ventajas y desafíos:

| Tipo de IA | Característica Clave | Ventaja | Riesgo/Limitación |

|---|---|---|---|

| Deep Learning (Redes Neuronales) | Aprende patrones de millones de kilómetros de conducción real y simulada. | Generaliza muy bien. Detecta peatones, señales, obstáculos incluso en casos nunca vistos. | "Caja negra": nadie sabe exactamente por qué el coche frenó. Difícil de validar antes de desplegar. |

| Lógica Experta/Reglas Codificadas | Ingenieros programan reglas explícitas: "Si velocidad > 80 km/h Y objeto enfrente < 50 m, frenar". | Totalmente transparente. Auditable. Predecible. Cumple regulaciones. | Frágil. No maneja casos anómalos bien. Requiere millones de líneas de código para cubrir todos los escenarios. |

| Métodos Híbridos (IA Explicable) | Combina deep learning con restricciones de seguridad y explicabilidad. | Balance entre precisión y transparencia. Facilita aprobación regulatoria. | Complejo de implementar. Requiere validación extremadamente rigurosa. |

El Dilema Ético: Caso Crítico en Directo

Ahora viene la pregunta que mantiene despiertos a los ingenieros y filósofos:

La respuesta no es técnica, es política. La UE, China y EE.UU. ya tienen respuestas diferentes. Europa tiende a proteger a los ocupantes del vehículo; otros países priorizan la vida de más personas aunque sean peatones.

Responsabilidad Legal y Regulación en 2025

La regulación de ADAS avanza lentamente pero avanza. En 2025, los estándares incluyen:

- ISO 26262 (Funcional Safety): Asegura que el sistema falla de forma segura. Si la IA no puede decidir, el coche frena.

- Regulación EU (AEB obligatorio desde 2022): El Frenado Automático de Emergencia es obligatorio en todos los vehículos nuevos. La IA detrás es la base de futuras regulaciones.

- Caja Negra Vehicular: Como en aviones, se registran todos los datos del vehículo 30 segundos antes del accidente. Esto permite investigar qué decidió la IA.

- Responsabilidad del Fabricante: Si la IA toma una decisión razonablemente segura dentro de sus parámetros entrenados, el fabricante NO es responsable. El conductor o propietario lo es si está disponible como backup.

El Desafío Abierto: Algoritmos Sesgados

Un riesgo crítico es que la IA perpetúe o amplifique sesgos. Si el modelo de deep learning fue entrenado principalmente con datos de peatones caucásicos, ¿detec correctamente a peatones de otras etnias en condiciones de baja luz? Investigaciones recientes muestran que algunos sistemas ADAS modernos tienen tasas de error 10x mayores para peatones de piel oscura.

La solución requiere transparencia, auditoría independiente y diversidad en los datos de entrenamiento. Algo que la industria apenas está comenzando.

Tu próximo coche puede ser más justo que tú. Mientras que los humanos tenemos prejuicios inconscientes, una IA bien diseñada puede tomar decisiones basadas únicamente en datos. Pero esa IA debe ser entrenada éticamente, supervisada legalmente y responsable públicamente.

Esta es la tercera entrega de nuestra serie ADAS 2025. Hemos explorado los ojos (sensores), la voz (V2X) y ahora el cerebro (IA). En el próximo artículo analizaremos el futuro regulatorio: ¿cómo Europa, China y EE.UU. aseguran que los coches autónomos sean seguros para todos?